扫二维码与项目经理沟通

我们在微信上24小时期待你的声音

解答本文疑问/技术咨询/运营咨询/技术建议/互联网交流

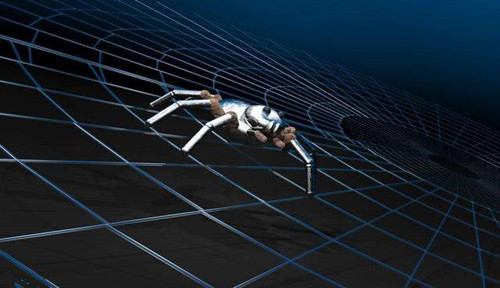

东莞网站优化需了解搜索引擎爬虫,搜索引擎爬虫指的是搜索引擎用在自動爬取页面的程序流程换句话说叫智能机器人。这种就是以某一个网站地址为起始点,去浏览,随后把页面存返回数据库中,这般持续循环系统,通常看来搜索引擎爬虫全是没超链接爬取的,因此 管它叫爬虫。他仅有开发设计搜索引擎才会采用。东莞网站优化中须利用超链接引向对应的页面,爬虫便会自動获取大家的页面。

聚焦爬虫原理及核心技术简述

东莞网站优化与互联网爬虫息息相关,爬虫是一个自動获取页面的程序流程,它为搜索引擎从Internet在网上下载页面,是搜索引擎的关键构成。传统式爬虫从一个或多个原始页面的URL刚开始,得到原始页面上的URL,在爬取页面的流程中,持续从当今页面上提取新的URL放进序列,直至考虑系统软件的相应终止标准。聚焦爬虫的工作内容比较繁杂,必须依据相应的网页分析优化算法滤除与主題没有关系的超链接,保存有效的超链接并将其放进等候爬取的URL序列。随后,它将依据相应的检索对策从序列中挑选接下来要爬取的页面URL,并反复所述流程,直至做到系统软件的某一标准时终止,此外,全部被爬虫爬取的页面可能被系统软件存储,开展相应的剖析、滤除,并创建数据库索引,便于以后的查寻和查找;针对聚焦爬虫而言,此过程中所获得的剖析結果还很有可能对之后的爬取流程得出意见反馈和具体指导。

相对性于通用性互联网爬虫,聚焦爬虫还必须处理3个关键难题:

对爬取总体目标的叙述或界定;

对页面或数据的分析与滤除;

对URL的检索对策。

爬取总体目标的叙述和界定是决策网页分析优化算法与URL检索对策怎样制定的基本。而网页分析优化算法和备选URL排序方法是决策搜索引擎所出示的服務方式和爬虫页面爬取手段的根本所在。

我们在微信上24小时期待你的声音

解答本文疑问/技术咨询/运营咨询/技术建议/互联网交流